[인사이드&인사이트]AI 시대 ‘고성능 메모리’ 강자가 시장 지배… 속도, 용량 혁신 전쟁

- 동아일보

-

입력 2024년 1월 14일 23시 33분

공유하기

글자크기 설정

메모리 불황 돌파구 HBM-CXL

《생성형 인공지능(AI) 시대가 본격적으로 열리며 메모리 반도체 시장도 새로운 국면을 맞이했다. 오픈AI의 챗GPT, 구글 제미나이, 삼성 가우스 등 AI는 이제 사람과 대화할 뿐만 아니라 요약, 정리 등 기본적인 업무부터 통역, 창작 등 고도화된 작업까지 해내고 있다. 정보를 읽고 기억하는 메모리에도 방대한 데이터를 빠르게 처리할 수 있는 높은 수준의 성능이 요구되는 것이다.정보기술(IT) 업계에서는 메모리 처리 속도가 지연되는 병목 현상을 해결하는 게 시급한 과제다. 기업들은 한계를 극복하기 위해 메모리 중에서도 D램 분야에서 혁신을 가속화하고 있다. 메모리 반도체는 한국이 전 세계 시장의 60%를 차지하고 있고 특히 AI 성능의 핵심인 D램 부문은 70%를 점유하고 있다. 세계가 삼성전자와 SK하이닉스가 있는 한국을 주목하는 이유다.》

9∼12일(현지 시간) 미국 라스베이거스에서 열린 세계 최대 IT·가전 전시회 ‘CES 2024’에서도 AI용 메모리 반도체는 핵심 화두였다. 삼성전자와 SK하이닉스 모두 고대역폭메모리(HBM) 5세대 제품과 컴퓨터익스프레스링크(CXL)라는 차세대 D램 기술을 선보였다. HBM은 속도에, CXL은 용량에서 혁신을 이뤄낸 D램 기술이다.

지난해 AI발 산업혁명으로 HBM이 침체에 빠진 반도체 시장의 구원투수가 됐다. 올해는 여기에 더해 CXL이 상용화되면 장기 불황에 빠졌던 메모리 산업이 반등할 수 있다는 전망이 나오고 있다.

● HBM, 1차선 도로가 16차선으로

HBM은 D램 여러 개를 수직으로 연결해 데이터 처리 속도를 획기적으로 끌어올린 메모리다. 집적도를 높여 공간 효율성은 물론이고 전력 효율도 뛰어나다. 대역폭이 현존 메모리 중 가장 넓어서 고대역폭이라고 불린다. 대역폭이란 쉽게 말해 ‘최대 속도’라고 생각하면 된다. 주어진 시간 내 얼마나 많은 데이터를 전송·처리할 수 있는가를 나타내는 개념으로 수치가 높을수록 빠르다는 의미다. HBM3 대역폭은 주로 비교되는 업계 최신 D램인 GDDR6보다 10배가량 높다. 그만큼 더 빠르다는 뜻이다.

HBM의 대역폭이 넓은 이유는 데이터가 오가는 입출력 통로(I/O) 수가 기존 D램보다 16배나 많아졌기 때문이다. 도로로 치면 1차선 도로를 달리다가 16차선 도로로 확 넓어진 셈이다. 일반 D램의 I/O가 64인 반면 HBM의 I/O는 1024에 달한다. HBM은 보통 8∼12개의 D램을 쌓아서 만드는데 각 D램마다 수직으로 오가는 1024개의 엘리베이터가 생겼다고 생각하면 된다. 수평 구조에서는 불가능한 설계다.

HBM 시장은 국내 기업들이 압도적인 우위를 점하고 있다. 트렌드포스에 따르면 지난해 삼성전자와 SK하이닉스가 각각 46∼49%를 차지한 것으로 추정된다. 나머지는 미국 마이크론이 한 자릿수 점유율을 가져갔지만 이마저도 구버전인 1∼3세대가 대부분이다.

메모리 업계는 4세대 제품에 대한 열기가 식기도 전에 벌써부터 5세대, 6세대 양산을 바쁘게 준비하고 있다. 5세대 제품인 HBM3E는 4세대 대비 속도가 50% 빨라져 초당 최대 1.2TB(테라바이트)를 처리할 수 있다고 한다. 이는 풀HD급 영화 230편 이상 분량의 데이터를 1초 만에 처리할 수 있는 수준이다.

● 용량, 효율성, 유연성 세 마리 토끼 잡는 CXL

이 때문에 엔비디아의 AI칩 GH200도 96GB HBM과 480GB LPDDR5X를 결합해 만들었다. LPDDR5X는 전력 효율이 우수한 저전력 D램으로 HBM 대비 속도는 느리지만 가격에서는 우위다.

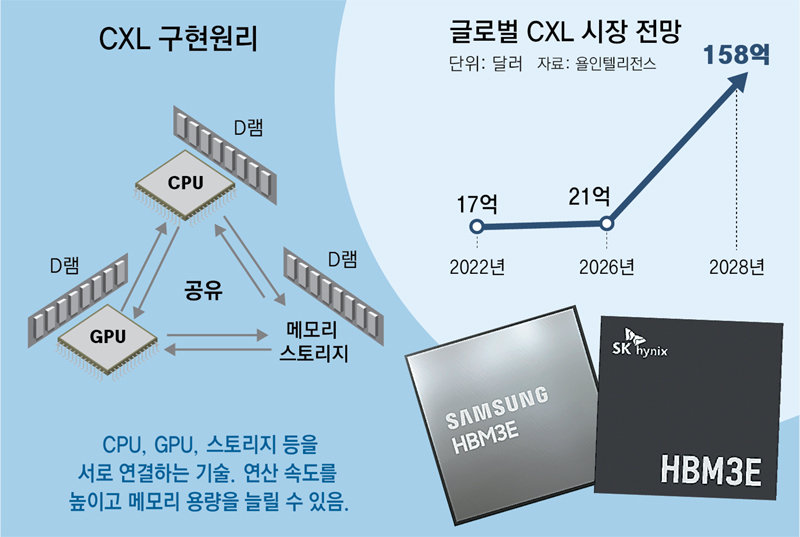

용량과 가격 문제를 해결하기 위한 기술이 CXL이다. HBM이 D램 여러 개를 쌓아 만든 패키징(포장) ‘제품’이라면 CXL은 구동 원리인 ‘인터페이스’다. 인터페이스는 중앙처리장치(CPU), GPU, 스토리지(저장장치) 등 기기 내 각 장치의 통신 연결 방식을 말한다.

기존 컴퓨팅 인터페이스는 CPU, GPU, 스토리지의 인터페이스가 제각각이어서 효율적인 연결이 어려웠고, 이는 AI 시대 병목 현상의 원인으로 꼽혔다. 각 장치마다 D램 등 메모리가 연동돼 있는데 연산 난이도가 높아지면서 메모리 간 협업 효율성이 떨어지는 것이다.

하지만 CXL이라는 하나의 인터페이스로 통일함으로써 각 장치끼리 메모리를 효율적으로 공유할 수 있는 길이 열렸다. 삼성전자, SK하이닉스, 인텔, 엔비디아, AMD 등 칩 업체를 비롯해 구글, MS, 메타 등 빅테크 업체들이 모여 CXL 컨소시엄을 구성하고 인터페이스를 하나로 합치는 작업에 착수한 것이다. CXL의 의미도 ‘Computer Express Link’, 즉 ‘빠르게 연결해서 연산한다’는 뜻이다.

CXL은 쉽게 표현하면 물컵과 물병에 비유된다. 5명의 사람이 물 1L씩 나눠 가지면 1L보다 더 마시는 사람과 덜 마시는 사람끼리 수시로 나눠야 해 번거롭다. 하지만 아예 5L짜리 병에 물을 전부 쏟아붓고 5명이 각각 필요한 만큼만 떠다 마시면 훨씬 쉽고 빠르게 물을 배분할 수 있는 것이다.

CXL의 장점은 시스템 연산 속도를 효율적으로 끌어올릴 수 있을 뿐만 아니라 메모리 용량을 획기적으로 확대할 수 있다는 유연성에도 있다. 이전에는 D램을 바꿔 쓰는 데도 규격이 맞는지 따지고 맞춰야 했다면 이제는 CXL 인터페이스만 따를 경우 다 해결되기 때문이다. 용량을 늘리고 싶으면 CXL 기반 메모리를 새롭게 꽂으면 끝인 것이다. CXL D램을 적용하면 서버 1대당 메모리 용량을 8∼10배가량 늘릴 수 있다고 한다.

삼성전자는 2021년 CXL 기반 D램 기술을 최초 개발했고 지난해 5월 CXL 2.0을 적용한 128GB D램을 개발했다. CXL은 1.1에서 2.0버전으로 가며 메모리 관리의 유연성이 획기적으로 향상됐다. 또 지난해 12월에는 리눅스 1위 기업 레드햇과 CXL 메모리 검증에 성공했다고 발표했다. SK하이닉스도 CXL 2.0 기반 96GB, 128GB D램 제품을 연내 상용화해 출시할 예정이다.

반도체업계 관계자는 “지금까지 반도체 용량과 성능을 발전시켰던 미세공정도 고도화가 정체되며 다양한 시도가 이뤄지고 있다”며 “HBM과 CXL도 패키징, 인터페이스 기술을 통해 한계를 극복하려는 것”이라고 말했다.

© dongA.com All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

트렌드뉴스

-

1

돈-칼 모두 쥔 ‘하메네이 문지기’…시위대 강경진압 주도

-

2

“유통기한 짧다” 교환 거부당하자 케이크 바닥에 내동댕이 [e글e글]

-

3

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

4

도박에 빠져…후임병 275명에 군복비 등 950만원 사기 친 20대

-

5

국힘, 90년대생 청년 인재 5명 영입…“지선 시대교체”

-

6

“‘모텔 약물 연쇄살인’ 20대女, 사이코패스 판명”

-

7

UAE 배치 ‘천궁-2’, 실전 첫 투입… 이란 미사일 요격

-

8

대구 도심 공사장서 천공기 쓰러져 택시 덮쳐…3명 부상

-

9

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

10

“혁명수비대 업은 강경파” vs “빈살만식 개혁 가능”…하메네이 차남 엇갈린 평가

-

1

“혁명수비대 업은 강경파” vs “빈살만식 개혁 가능”…하메네이 차남 엇갈린 평가

-

2

“정파적 우편향 사상, 신앙과 연결도 신자 가스라이팅도 안돼”

-

3

“한국 교회 큰 위기…설교 강단서 복음의 본질 회복해야”

-

4

韓증시 아직 못믿나…중동전 터지자 외국인 5조원 ‘썰물’

-

5

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

6

李 “檢 수사·기소권으로 증거조작…강도·살인보다 나쁜 짓”

-

7

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

8

‘공천헌금’ 의혹 강선우·김경 동시 구속…“증거 인멸 염려”

-

9

정청래 “조희대, 사법개혁 저항군 우두머리냐? 사퇴도 타이밍 있다”

-

10

미스 이란 출신 모델 “하메네이 사망, 많은 국민이 기뻐해”

트렌드뉴스

-

1

돈-칼 모두 쥔 ‘하메네이 문지기’…시위대 강경진압 주도

-

2

“유통기한 짧다” 교환 거부당하자 케이크 바닥에 내동댕이 [e글e글]

-

3

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

4

도박에 빠져…후임병 275명에 군복비 등 950만원 사기 친 20대

-

5

국힘, 90년대생 청년 인재 5명 영입…“지선 시대교체”

-

6

“‘모텔 약물 연쇄살인’ 20대女, 사이코패스 판명”

-

7

UAE 배치 ‘천궁-2’, 실전 첫 투입… 이란 미사일 요격

-

8

대구 도심 공사장서 천공기 쓰러져 택시 덮쳐…3명 부상

-

9

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

10

“혁명수비대 업은 강경파” vs “빈살만식 개혁 가능”…하메네이 차남 엇갈린 평가

-

1

“혁명수비대 업은 강경파” vs “빈살만식 개혁 가능”…하메네이 차남 엇갈린 평가

-

2

“정파적 우편향 사상, 신앙과 연결도 신자 가스라이팅도 안돼”

-

3

“한국 교회 큰 위기…설교 강단서 복음의 본질 회복해야”

-

4

韓증시 아직 못믿나…중동전 터지자 외국인 5조원 ‘썰물’

-

5

주가 폭락에…코스피·코스닥 서킷브레이커 발동

-

6

李 “檢 수사·기소권으로 증거조작…강도·살인보다 나쁜 짓”

-

7

“美, 하메네이처럼 김정은 제거 어렵다…北, 한국에 핵무기 쏠 위험”

-

8

‘공천헌금’ 의혹 강선우·김경 동시 구속…“증거 인멸 염려”

-

9

정청래 “조희대, 사법개혁 저항군 우두머리냐? 사퇴도 타이밍 있다”

-

10

미스 이란 출신 모델 “하메네이 사망, 많은 국민이 기뻐해”

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

![조코비치 선수생명 늘린 한마디 “글루텐 끊어보시죠”[인사이드&인사이트]](https://dimg.donga.com/a/180/101/95/2/wps/NEWS/IMAGE/2024/01/15/123064510.2.jpg)

댓글 0