구글 이어 아마존… ‘AI칩 삼국지’ 달아오른다

- 동아일보

-

입력 2025년 12월 4일 03시 00분

공유하기

글자크기 설정

빅테크들, 엔비디아 독주에 도전장

아마존 “성능↑ 전력↓” 칩 공개

구글 TPU도 ‘전성비’ 끌어올려

모델 구조 맞춰 전용칩 잇단 개발… 90% 장악 엔비디아 “아직 멀었다”

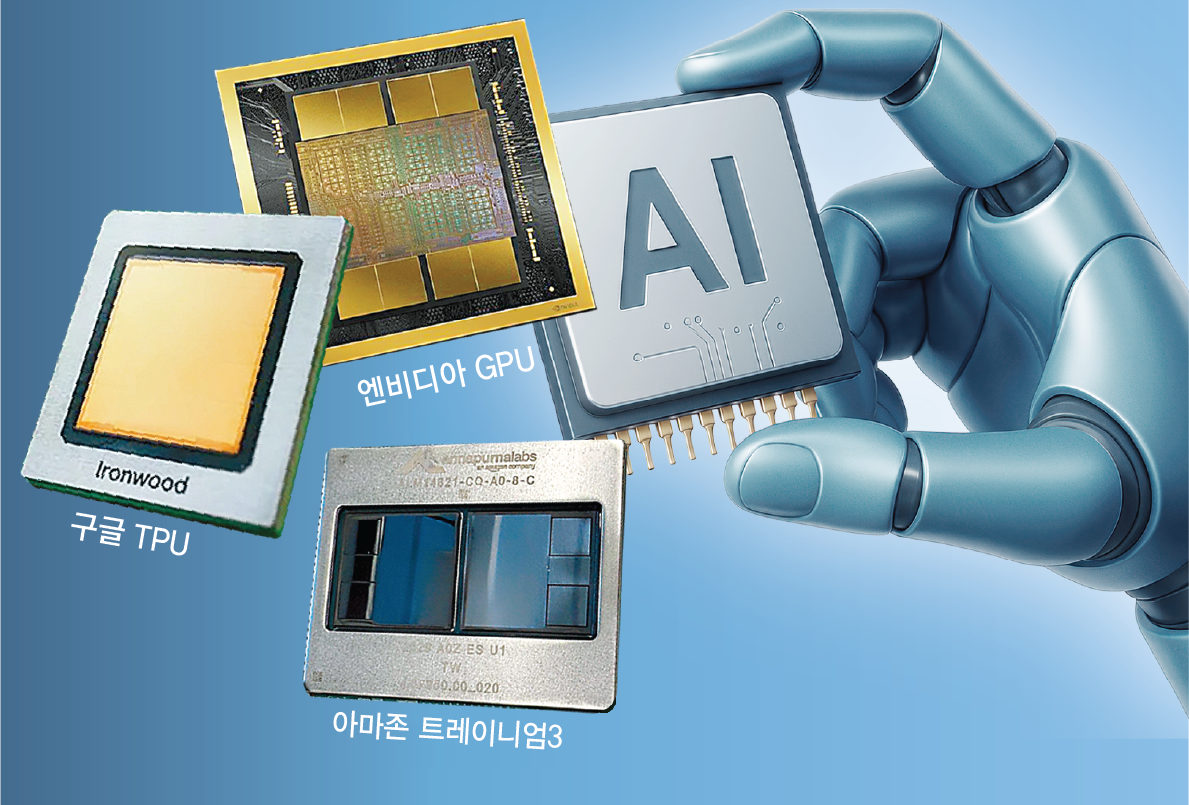

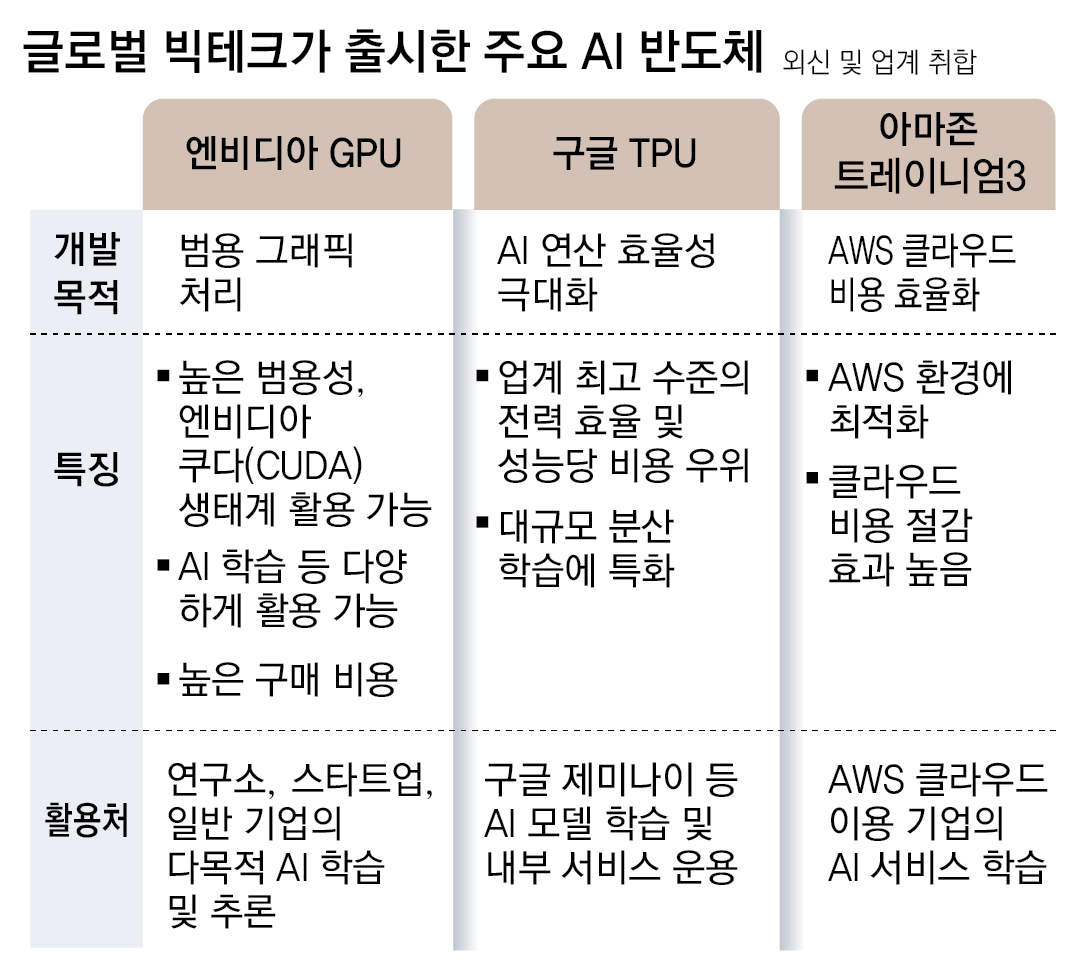

구글에 이어 아마존웹서비스(AWS)가 전력 효율성을 끌어올린 자체 인공지능(AI) 칩을 출시하며 그동안 엔비디아가 장악해 온 AI 칩 시장에 변화 조짐이 나타나고 있다. 초대형 모델 학습 수요가 급증하는 가운데, 비용·전력·공급망 부담이 누적되자 기업들이 연산 구조를 직접 설계하는 전략을 택했다는 평가가 나온다. 이른바 ‘전성비(전력 대비 성능)’를 끌어올린 빅테크들의 자체 AI 칩이 엔비디아의 독보적인 지위에 균열을 낼 수 있을지 관심이 쏠리고 있다.

● 자체 칩 개발 나선 구글, 아마존, 오픈AI

AWS는 2일(현지 시간) 미국 라스베이거스에서 열린 연례 행사 ‘AWS 리인벤트 2025’에서 맞춤형 AI 칩인 ‘트레이니엄3’를 공식 출시한다고 밝혔다. AWS는 트레이니엄3 칩이 최대 144개 탑재된 울트라 서버를 출시했으며 이날부터 이용할 수 있다고 설명했다.

구글이 자체 개발한 텐서처리장치(TPU)도 마찬가지로 적은 전력 소모량과 운영 비용 감축을 강점으로 한다. TPU는 최근 공개돼 호평을 받은 구글의 AI 모델 ‘제미나이3’의 학습 및 구동을 주도한 AI 칩으로, 구글이 미국 반도체 팹리스(설계) 기업인 브로드컴과 함께 만들었다. AI 스타트업 앤스로픽은 최대 100만 개의 TPU를 사용해 AI 모델을 개발할 예정이며, 메타도 자체 데이터센터에 구글 TPU를 도입할 것으로 전해졌다. 오픈AI도 브로드컴과 함께 챗GPT 등 오픈AI의 AI 모델 훈련, 실행을 위한 자체 AI 칩을 공동 개발하기로 했다.

● 공급 부족 GPU 대체

기업별로 서비스 특성이 다른 점도 자체 AI 칩 개발의 이유가 됐다. 가령 AWS는 클라우드, 구글은 제미나이 같은 대규모언어모델(LLM) 학습을 위한 AI 칩이 필요한 상황이라 여기에 맞는 AI 칩을 개발한 것이다. 범용으로 사용되는 GPU는 대부분의 연산을 처리할 수 있지만, 특정 기업의 모델 구조에 맞춰 설계된 전용 칩은 같은 양의 연산을 더 낮은 전력으로 처리할 수 있다.

다만 업계에선 AI 칩과 관련해 엔비디아의 독점적 지위가 바로 흔들리지는 않을 것이란 분석이 많다. 현재 전 세계 AI 연구개발(R&D) 환경은 엔비디아 GPU와 엔비디아의 소프트웨어 플랫폼인 쿠다(CUDA) 생태계를 중심으로 구축돼 있다. 이미 투자한 인프라 규모와 전환 비용을 고려하면 당장 다른 AI 칩으로 바꿀 가능성이 높지 않다는 것이다. 엔비디아는 최근 “구글이 AI 분야에서 큰 진전을 이뤘다”면서도 “(우리 제품이) 업계보다 한 세대 앞서 있다”고 자신감을 드러냈다.

© dongA.com All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

트렌드뉴스

-

1

[단독]주한미군 패트리엇 ‘오산기지’ 이동… 수송기도 배치

-

2

美, 최신예 미사일 ‘프리즘’ 이란서 처음 쐈다…“추종 불허 전력”

-

3

아침 공복 따뜻한 물 한 잔, 정말 살 빠지고 해독될까?[건강팩트체크]

-

4

‘빅마마’ 이혜정, 금수저 집안이었다…“父 유한킴벌리 초대 회장”

-

5

추미애 “공소청법, 제왕적 검찰총장 못 막아”…정부안에 반발

-

6

관절 연골 안써야 안닳는다? 되레 움직여야 회복돼[노화설계]

-

7

“휴일 없이 한 달 내내 일했다”…태국인 노동자 ‘400만원’ 월급명세서 화제

-

8

[단독]“두건 쓴 무장경비대 길목마다 검문…택시로 20시간 달려 탈출”

-

9

“맨홀에 끼여 발목 뼈 산산조각” 엄지원, 日 여행중 긴급수술

-

10

공부도, 당구도 1등…‘당구계 엄친딸’ 허채원 “둘 다 놓치고 싶지 않아”

-

1

배현진 징계 효력 중지…“장동혁 지금이라도 반성하라”

-

2

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

3

李 “‘다음은 北’ 이상한 소리하는 사람 있어…무슨 득 있나”

-

4

법원, 장동혁 지도부의 배현진 징계 효력정지

-

5

사전투표함 받침대 투명하게 바꾼다… 부정선거 의혹 차단

-

6

[단독]주한미군 패트리엇 ‘오산기지’ 이동… 수송기도 배치

-

7

“우리 아들-딸 왜 죽어야하나” 항의…팔 부러진채 끌려나갔다

-

8

與 경남도지사 후보 김경수 단수 공천

-

9

김어준에 발끈한 총리실…“중동 대책회의 없다고? 매일 챙겼다”

-

10

李 “기름값 담합은 중대범죄…악덕기업, 대가 곧 알게될 것”

트렌드뉴스

-

1

[단독]주한미군 패트리엇 ‘오산기지’ 이동… 수송기도 배치

-

2

美, 최신예 미사일 ‘프리즘’ 이란서 처음 쐈다…“추종 불허 전력”

-

3

아침 공복 따뜻한 물 한 잔, 정말 살 빠지고 해독될까?[건강팩트체크]

-

4

‘빅마마’ 이혜정, 금수저 집안이었다…“父 유한킴벌리 초대 회장”

-

5

추미애 “공소청법, 제왕적 검찰총장 못 막아”…정부안에 반발

-

6

관절 연골 안써야 안닳는다? 되레 움직여야 회복돼[노화설계]

-

7

“휴일 없이 한 달 내내 일했다”…태국인 노동자 ‘400만원’ 월급명세서 화제

-

8

[단독]“두건 쓴 무장경비대 길목마다 검문…택시로 20시간 달려 탈출”

-

9

“맨홀에 끼여 발목 뼈 산산조각” 엄지원, 日 여행중 긴급수술

-

10

공부도, 당구도 1등…‘당구계 엄친딸’ 허채원 “둘 다 놓치고 싶지 않아”

-

1

배현진 징계 효력 중지…“장동혁 지금이라도 반성하라”

-

2

李 “주유소 휘발유 값 폭등…돈이 마귀라지만 너무 심해”

-

3

李 “‘다음은 北’ 이상한 소리하는 사람 있어…무슨 득 있나”

-

4

법원, 장동혁 지도부의 배현진 징계 효력정지

-

5

사전투표함 받침대 투명하게 바꾼다… 부정선거 의혹 차단

-

6

[단독]주한미군 패트리엇 ‘오산기지’ 이동… 수송기도 배치

-

7

“우리 아들-딸 왜 죽어야하나” 항의…팔 부러진채 끌려나갔다

-

8

與 경남도지사 후보 김경수 단수 공천

-

9

김어준에 발끈한 총리실…“중동 대책회의 없다고? 매일 챙겼다”

-

10

李 “기름값 담합은 중대범죄…악덕기업, 대가 곧 알게될 것”

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

댓글 0