챗GPT·소라 말고 그 다음! 스스로 체득하는 AI로봇이 온다[딥다이브]

- 동아일보

-

입력 2024년 2월 28일 10시 00분

공유하기

글자크기 설정

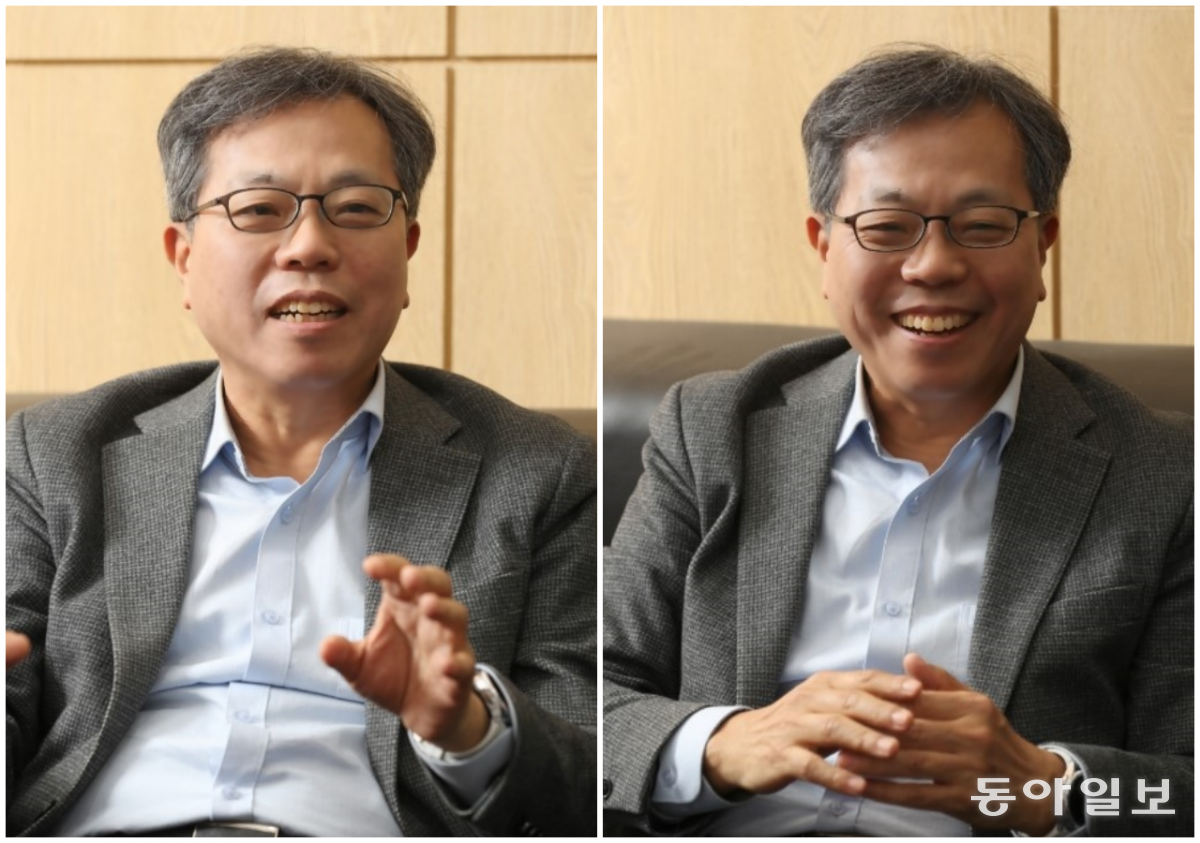

그럼 우리도 얼른 뒤쫓아가자고요? 글쎄요. 어차피 이미 늦었는데, 건너뛰고 다음 단계로 나아가면 어떨까요. 그 다음이라 함은 바로 AI 로봇을 일컫습니다. 글·이미지·영상 자료로 학습하는 게 아니라, 오감을 사용해 사람처럼 스스로 체험하면서 학습하는 AI이죠. 서울대 AI연구원 교수 세 분과 함께 인공지능의 미래, AI 로봇에 대해 이야기 나눴습니다. 장병탁 서울대 AI연구원 원장, 박재흥 서울대 융합과학기술대학원 교수, 김현진 서울대 항공우주공학과 교수를 함께 만났습니다.

*이 기사는 27일 발행한 딥다이브 뉴스레터의 온라인 기사 버전입니다. ‘읽다 보면 빠져드는 경제뉴스’ 딥다이브를 뉴스레터로 구독하세요.

https://www.donga.com/news/Newsletter

오감으로 학습하는 AI 로봇이 온다

-챗GPT 탄생 이후 생성형 AI 서비스로 세상이 들썩이죠. 세분은 AI와 로봇을 일찍부터 연구하셨는데요. 이런 시대가 곧 올 거라고 생각하셨나요?장병탁 원장=“옛날 AI는 사람이 아는 지식을 자꾸 넣어주려고 했어요. 전 그렇게 해선 멀리 못 간다, 자기가 스스로 배워야 한다고 생각했죠. ‘기계가 학습한다’는 개념인데요. 사실 1980년대만 해도 이게 이렇게 파급 효과가 클 줄은 몰랐는데요. AI 기술이 달라지면서, 이제 AI 로봇이 만들어질 수 있는 때가 됐습니다.”

-지금도 산업현장에서 로봇이 많이 쓰이죠. 하지만 그건 일일이 사람이 프로그래밍해야 작동하는데요.

김현진 교수=“예컨대 로봇 팔 길이가 얼마, 무게가 얼마인지 알면 수식을 쓸 수 있죠. 그 수식을 풀면 로봇이 어떻게 동작할지 알고요. 제가 예전에 공부했던 제어 분야에선 그렇게 했는데요. 요즘 AI 쪽에서 로봇을 연구하는 분들은 ‘그런 거 다 몰라도 돼. 나는 모른다고 하고 개발할 거야’라고 합니다. 물론 처음엔 당연히 잘 안되죠.”

김 교수=“그래서 옛날식으로 로봇을 연구하는 사람들은 ‘그거 우리가 재면 되는데 왜 모른다고 하고 시작하니?’라고 하고요. AI 쪽은 ‘지금 우리는 그 정보를 안 쓰니까 처음엔 못할지 모르지만, 이렇게 계속 학습해나가면 너네보다 나중엔 더 잘할 수 있어’라는 철학이에요.”

장 원장=“프로그래밍한 건 사람이 생각한 디자인은 잘하지만 확장성이 없죠. 지금 챗GPT가 이전과 다른 것도, 옛날엔 ‘무슨 단어가 나오면 다음엔 무슨 단어라고 말해’라고 프로그램 해줬어요. 지금은 그렇게 안 하죠. ‘I love’ 다음에 뭐가 나오는지 문장을 다 학습해서, 확률적으로 답을 해요. 그래서 엉뚱한 말도 하지만.”

장 원장=“로봇은 범용적인 걸 해야 하거든요. 한가지 정해진 것만 하는 건 옛날 방식으로도 잘할 수 있어요. 지금 공장에서 쓰이는 로봇이 그렇죠. 그런데 (탁자 위 물컵을 가리키며) 이걸 치우는 로봇이라면 물컵이 이쪽에 있거나, 저쪽에 있거나 다 치울 수 있어야 하거든요. 이걸 다 프로그래밍하는 건 거의 불가능하죠.”

몸을 가지고 배우는 알로하

-최근에 ‘AI가 몸을 가지고 배워야 한다’는 이야기를 많이 하셨더라고요.장 원장=“챗GPT는 글자만 가지고 세상을 감지합니다. 전 세상 문서를 다 읽은 셈이죠. 그다음 이제 영상이 오고 있는데, 아직은 잘 못해요. (생수병을 들면서) 이걸 보면 ‘물병이다’라고 인식하는 정도이고요. 제가 (생수병을 반쯤 숨기며) 이렇게만 보여주면 알지 못하죠. 그런데 움직일 수 있는 로봇은 이쪽 편으로 와서 보면 알 수 있어요. 그래서 몸이 있으면 훨씬 똑똑해질 수 있습니다. (물컵을 들며) 이게 뭔지 진짜 알려면 만져 보고 들어 보고 하면서 배워야 하거든요. 이제 AI가 그렇게 가야 하죠.”

-그런 AI 로봇 연구 사례 중에 재미있는 게 있으면 소개해주시죠.

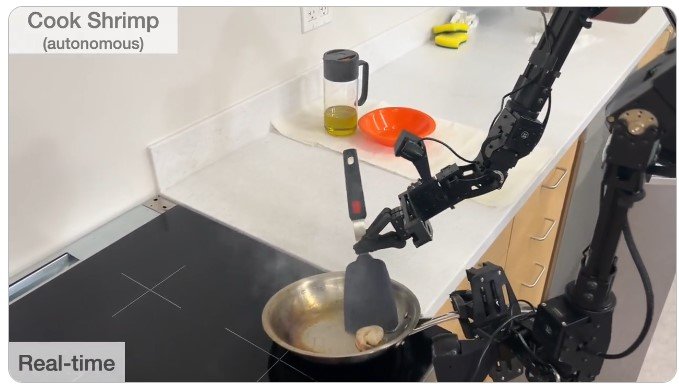

질문을 하자마자 세 교수 모두 ‘알로하’를 떠올렸다. 미국 스탠퍼드대 연구팀이 구글 딥마인드와 협력해서 개발한 가사노동 AI 로봇이다. 프라이팬에 새우를 굽고 설거지도 척척 하는 양팔 로봇의 영상이 지난달 공개됐고, 세계 로봇 연구계가 뒤집혔다.

-아바타 로봇이 단순히 사람 동작을 따라만 하는 게 아니라, 그걸 데이터 삼아 스스로 학습하기까지 하는군요.

박재흥 교수=“지금 기술 수준은 거기까지(동작을 따라 함)인데, AI 기술을 합하면 되는 거죠.”

-일단 새우 굽는 법을 가르치면 AI 로봇이 나중엔 다른 요리까지 만들게 될지도 모르겠어요.

장 원장=“AI 발전 관점에서 로봇이 진짜 중요한 이유가 그거예요. 몸과 센서, 액추에이터(원동기)가 있으면 기계 스스로 학습할 수 있어요. 지금은 ‘이건 물컵이야. 떨어뜨리면 깨져. 소리가 나’라고 일일이 가르쳐줘야 하는데요. 로봇이 듣고 움직일 수 있으면 안 가르쳐줘도 스스로 알 수 있죠. 지금 세상을 바꾼 게 ‘머신러닝’인데, 그 머신러닝의 한계를 넘어설 수 있는 게 AI 로봇이에요.”

-서울대에선 지난해 3월부터 팔을 가진 AI 로봇를 연구하셨죠?

장 원장=“챗GPT가 전 세상 인터넷 문서를 다 읽어 머릿속에 넣어놓고 즉답을 하거든요. 그런데 로봇은 따로 있었어요. 로봇은 몸만 있지 말은 못 했고, 챗GPT는 말은 많은데 몸은 없죠. 그 둘이 결합되는 시도가 지금 막 일어나는 겁니다.”

-서울대가 개발한 로봇팔은 ‘빨간 컵 집어줘’라고 명령하면 척척 하더라고요.

장 원장=“그 로봇은 말로 가르칠 수도 있어요. 예컨대 ‘손가락을 열고, 물병에 가까이 가서 집어’라고 말을 하면 로봇이 그 행동을 따라 해서 물병 집는 법을 배우죠.”

범용 로봇은 코딩 대신 AI가 필요하다

-AI가 몸을 가지면 많은 일을 할 수 있겠습니다. 일본에선 간병인력이나 택배기사 부족과 관련해 로봇을 대안으로 많이 제시하더라고요.장 원장=“그게 사실 지금의 AI 서비스보다 파급력이 훨씬 크죠.”

-박 교수님이 개발하신 심폐소생술 로봇도 그런 점에서 필요한 기술이죠.

박 교수=“심폐소생술 로봇은 특수목적인데요. 사람들이 생각하는 건 매우 범용적인 로봇이죠. 이것도 해주고, 저것도 해주는.”

김 교수=“예를 들면 휴머노이드(인간 같은 로봇) 한 대가 이 건물에서 경비도 서고, 조리도 하고, 심폐소생도 하고, 안내도 하고, 무거운 것도 들어주고. 이런 걸 생각하죠.”

-결국 범용으로 가긴 가야 할 텐데, 아직은 특수한 목적의 로봇 위주이로군요.

박 교수=“그게 가격 경쟁력과도 연관됩니다. 예를 들어 요즘 서빙로봇이 많이 나오지만 사람은 서빙만 하지 않거든요. 청소도 하고 이야기도 나누기도 하고 가치가 더 크죠. 지금의 로봇은 특수목적이니까 가격이 싼 것 같으면서도 약간 애매해요. 그래서 사기엔 부담되죠.”

장 원장=“식당은 새마을식당도 있고 아웃백스테이크도 있잖아요. 다양한 상황이 있다 보니까 그동안은 범용으로 가기가 어려웠죠. 로봇이 지각을 가지고 스스로 학습하게 해야 하는데, 지금까지 개발하는 방법은 일일이 다 코딩해주는 거였으니까요. 아이들 교육하는 것과 비슷해요. 자꾸 암기식으로 집어넣어 주면, 당장은 잘하는 것처럼 보이지만 멀리 못 가죠. AI는 그게 아니라 애들을 박물관 데려가고 놀게 해주는 셈이죠.”

김 교수=“내일 시험을 잘 보려면 내용은 잘 몰라고 무조건 외우면 조금이라도 맞을 것 같잖아요. 그런데 계속 그렇게만 할 순 없는 거죠. 수년 후에도 공부를 잘하게 하려면 스스로 학습하게 해야 해요. 지금 AI가 그렇게 가는 거죠.”

LLM은 늦었지만 AI로봇은 이제 시작

장 원장=“텍스트를 가지고 챗GPT를 만드는 건 사실 이미 많이 늦었어요. 그건 이제 자본 싸움, 컴퓨팅 파워 싸움이죠. 하지만 로봇이 오감을 데이터화해 학습하게 하는 건 이제 시작이에요. 똑같은 출발이죠. 그래서 로봇 개발에 집중하는 AI는 우리나라가 잘할 수 있죠. 제조업하고도 연결되니까요.”

-거대언어모델을 우리가 새로 구축하자는 식의 작업은 돈도 많이 들고, 이미 늦었는데요. 그에 비하면 AI 로봇은 늦지 않았군요?

김 교수=“거대언어모델(LLM)을 쓰는 로봇 연구가 한 1년 정도 전에 시작된 수준이거든요. 아까 본 알로하 로봇도 세계에서 제일 잘한다고 하지만 (연구 기간이) 5년 안쪽이고요.”

장 원장= “어떻게 보면 AI 연구자들이 그걸 놓친 거예요.”

-그동안 남들이 놓쳤기 때문에 우리가 잘할 수 있겠군요.

장 원장=“못할 게 없어요.”

중국의 로봇 굴기가 걱정스러운 이유

김 교수=“중국은 키워야 하는 분야는 정부가 무조건 밀어주는 데다, 중국 시장 안에서 자급자족이 됩니다. 그게 바로 선순환 사이클의 시작이죠.”

-하지만 중국이 아직 ‘스스로 학습하는’ AI 로봇에 있어서는 기술력이 앞서 나가진 못하겠죠?

김 교수=“네. 아마 우리와 비등비등할 것 같은데, 문제는 인력 숫자죠. 예를 들면 우리 연구실에서 10명의 대학원생이 아바타 로봇을 통해 데이터를 모으는 것과 중국에서 1000명이 모으는 건 비교도 안 되잖아요.”

박 교수=“개발 인력도 차이가 크죠.”

김 교수=“보통 AI나 로봇 분야는 논문을 쓰면 코드를 공개하거든요. 그 코드가 올라가면 중국 기업과 대학엔 그걸 열심히 뒤지는 사람들이 충분한 거죠. 그래서 괜찮은 게 새로 나오면 바로 갖다 써보고, 고칠 부분은 고쳐보니까요. 약점을 파악해서 더 나은 것을 만드는 걸 훨씬 빨리할 수 있어요.”

장 원장=“인구나 투자 면에서 중국이 무섭긴 무서워요.”

박 교수=“요즘 미국에서 나온 (AI나 로봇 관련) 논문을 보면 저자 중에 중국인이 없는 경우가 별로 없어요. 저자 중 한 명은 중국인이죠. 그 사람은 언젠가 중국에서 뭔가 할 거고요.”

김 교수=“저희 대학원생이 구글과 AI 논문을 쓰는 중이었는데, 어떻게 알았는지 틱톡에서 연락이 왔어요. 자기네 인턴으로 오라고요. 틱톡이 제시한 조건이 미국 빅테크보다 좋더라고요.”

-중국 출신만이 아니라 전 세계 인력 중 좋은 사람을 계속 찾아서 데려가고 있군요. 엄청 빠르네요. 한국 기업들은 그렇게 빠릿빠릿하진 않나요?

김 교수=“학생들 입장에선 매력이 없죠. 외국 기업은 제시하는 연봉 숫자가 한국의 몇 배이거든요. 제가 졸업할 때만 해도 구글이 10만 달러 준다고 들었는데, 요즘엔 톱 수준 졸업생은 40만 달러를 제시한다더라고요.”

미국은 휴머노이드 로봇 투자 붐 시작

김 교수=“발전 속도를 보면 훌륭하죠.”

-옵티머스는 범용 로봇이 될 수 있을까요.

박 교수=“기본적으로는 테슬라 공장에서 쓰려는 거죠.”

김 교수=“그런데 휴머노이드 로봇이 잘 동작하면 사실 집에 넣을 수 있는 플랫폼이에요. 예를 들면 문턱이 있어도 되고, 계단이 있어도 되니까요.”

장 원장=“다만 가격이. 애초에 2만 달러로 만든다고 했는데, 지금으로서는 불가능하죠. 로봇팔 하나만 해도 2000만원이 들거든요.”

김 교수=“박 교수님이 보시기에 옵티머스를 똑같이 연구실에서 만들면 얼마나 돈이 들까요?”

박 교수=“아마 한 30만 달러 정도 들겠죠. 인건비 계산 안 하고, 원가만 했을 때. 그런데 지난해 휴머노이드 학회에 갔을 때 한 회사에서 이런 얘기를 하더라고요. ‘진짜 원재료, 즉 쇠 값만 따져보면 차보다 쌀 수도 있다’고요.”

-차보다 크기가 작으니까요?

박 교수=“그러니까 결국 생산의 문제인 겁니다. 자동차가 사실 되게 복잡하거든요. 그런데 엄청나게 발전해서 이 정도 가격이 된 거예요. 휴머노이드 로봇이 진짜로 필요하다면, 사람들이 노력해서 자동차보다 싸질 수도 있다고 얘기하는 거죠.”

박 교수=“차는 너무나 유용한데, 휴머노이드 로봇은 아직 할 수 있는 게 별로 없잖아요. 그런데 이게 유용하다는 걸 보여주면 결국 발전할 수 있다, 왜 2만 달러가 안 되겠느냐, 이런 얘기를 하더라고요.”

장 원장=“로봇이 노동자 1명을 명확히 대체할 수 있으면 사실 가능하죠.”

박 교수=“테슬라는 자동차 조립 공정에서 사람 노동자를 없애려고 엄청나게 노력하거든요. 옵티머스를 통해 사람을 아예 다 없애려고 하는 겁니다.”

장 원장=“좁은 공간에서 몸을 비틀어서 해야 하는 일, 기본적으로 위험할 수 있는 일도 휴머노이드 로봇이 필요해요.”

-지금 공장에 세팅된 그런 로봇이 아닌, 휴머노이드 로봇이 있어서 진짜 사람처럼 일을 시킬 수 있으면 생산성은 엄청나겠네요. 그런데 언제나 될까요?

박 교수=“빨리 될 수도 있죠. 지금 테슬라를 포함해 미국에서는 휴머노이드 로봇에 진짜 투자를 많이 합니다.”

-투자자들은 정말 그게 곧 된다고 보는 건가요?

장 원장=“투자자들은 ‘다음’을 찾아야 하니까요. 전 그게 부러워요. 우리나라에선 그런 움직임이 일어나지 않는데 실리콘밸리는 이미 그리로 가니까요. 그래서 미국이 선도하는 거예요. 지금 보면 그들이 너무 앞서가는 것처럼 보이지만, 사실 투자자들이 만들어가는 거죠.”

-‘다음은 이거다’라고 여기면 ‘이게 될까?’라는 의문이 있어도 일단 가는군요.

장 원장=“그렇게 어마어마한 돈을 투자하면 거기에 똑똑한 사람들이 와요. 그럼 생각하지 못한 게 나오죠. 지금 챗GPT도 바로 그런 겁니다. 그래야 선도하는 거고요.”

대기업이 로봇 투자 화끈하게 못 하는 이유

장 원장=“부가가치가 높다는 건 남들이 다 알 때 시작한 게 아니라 먼저 시작한 거예요. 그리고 그 격차를 벌려놓은 거고요. 그렇게 해야 때를 만나면 막 치고 나갈 수 있죠.”

김 교수=“한국 대기업도 로봇이 언젠가는 뜰 거라는 걸 10년 전에도 알았죠. 그런데 당시엔 시장이 안 보였죠. 공공연하게 기업에선 얘기하더라고요. ‘1조원의 시장이 보이지 않으면 우리는 들어가지 않는다’고요. 그런데 그렇게 때를 놓치면 10년 또는 20년 뒤에 들어가서 주도할 수 있을까요.”

장 원장=“로봇은 AI 응용의 임팩트가 확 달라요. 지금까진 AI가 정신노동만 했는데, 로봇은 몸으로 하는 일을 할 수 있죠. 고령화, 인구감소, 노동력 감소 문제는 올 수밖에 없잖아요. 그런 일을 AI가 대신해준다면 그게 바로 로봇이에요. 또 원천기술 관점에서 ‘할루시네이션(환각, Hallucination)을 없애는 방법이기도 해요. 지금은 언어와 시각 데이터만 있는데, AI 학습에 터치(촉각) 정보만 추가돼도 할루시네이션은 확 줄일 수 있죠.”

-명백히 로봇이 다음 AI 기술 발전의 단계인데, 문제는 대기업 입장에선 아직 시장이 보이지 않는다는 거로군요.

김 교수=“대기업 입장에서 보면 시장에 내놓고 팔 만큼 자신있는 로봇을 만들 수가 없는 거죠. 착용형 웨어러블 로봇이라고 부르는 보행을 도와주는 로봇이 있는데요. 삼성이 그걸 출시할까 말까 고민하다 하지 않은 이유 중 하나가 삼성의 브랜드를 달고 나갔는데 만약 그 이용자가 실수로 넘어져요. 그래도 고객이 제품 때문에 넘어졌다고 할 수 있잖아요. 삼성은 기업 이미지가 너무 중요한데, 그 작은 시장을 위해 그런 걸 감수할 수가 없는 거죠.”

장 원장=“구글이 오픈AI보다 AI 챗봇에서 늦은 이유가 그거죠. 할루시네이션은 생성형 AI의 근본적인 문제인데, 구글이 그것 때문에 계속 머뭇머뭇했고요. 오픈AI는 스타트업이니까 잃을 게 없었고요.”

-오픈AI는 ‘일단 서비스하고, 그다음에 고치자’라는 식이로군요.

장 원장=“챗GPT의 경우, 전 인류가 AI를 가르치고 있는 셈이에요. 여전히 학습하고 있는 거죠. 그렇게 하니까 구글이 하지 못한 걸 스타트업이 먼저 해낸 거죠.”

김 교수=“한국 같은 작은 나라에선 대기업이 돈이 없거나 미래를 몰라서 안 하는 건 아니지만, 나서서 하기 어려운 부분도 분명히 있죠. 그런 걸 할 수 있는 스타트업을 더 키워주거나 하는 게 정부가 할 일이 아닐까 싶어요.” By.딥다이브

줄인다고 줄였는데도 인터뷰 기사가 꽤 길어졌습니다. 벌써부터 ‘너무 길다’는 반응이 올 게 걱정되네요. AI가 아니라 인간이 쓰다 보니, 화끈하게 팍팍 잘라서 쳐내는 게 잘 안되는 점 이해해주십시오. 주요 내용을 요약해드리자면

-글, 이미지, 영상만 가지고 학습하던 AI가 몸을 가지면 어떻게 진화할까요. 오감을 느끼며 직접 세상을 체득하는 AI 로봇 시대가 다가옵니다.

-AI와 로봇이 만나면 우리가 꿈꾸던 ‘범용 로봇’이 가능해질 겁니다. 생성형 AI의 약점인 환각 현상도 크게 줄일 수 있겠죠. AI가 정신노동뿐 아니라 육체노동까지 대신해준다는 점이 특히 매력적입니다. 이 분야는 전 세계가 출발하는 단계로, 한국이 잘할 수 있는 영역입니다.

-물론 가격은 가장 큰 걸림돌이죠. 하지만 AI 로봇이 그 필요성을 입증해서 대량생산 시대가 열린다면 가격을 낮추는 것도 가능하지 않을까요.

-미국은 휴머노이드 로봇 투자 붐이 일고 있습니다. AI의 다음 단계를 선점하려는 발 빠른 움직임인데요. ‘시장이 보이지 않는다’며 주저하다가는 영영 산업을 선도하지 못할 수 있습니다.

*이 기사는 27일 발행한 딥다이브 뉴스레터의 온라인 기사 버전입니다. ‘읽다 보면 빠져드는 경제뉴스’ 딥다이브를 뉴스레터로 구독하세요.

https://www.donga.com/news/Newsletter

© dongA.com All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

트렌드뉴스

-

1

‘찐명’ 한준호, 김어준 직격 “지라시도 안되는 음모론으로 李정부 공격”

-

2

“머리 감기기 힘들다” 의식없는 노모 삭발한 간병인, 격분한 딸이 폭행

-

3

“실수 봐준 고깃집에 돈쭐 내주자”…인부 18명이 고기 주문

-

4

SK하이닉스 “6세대 LPDDR6 세계 첫 개발”…모바일용 D램도 고도화

-

5

‘독도 마지막 주민’ 김신열 씨 별세…등록된 민간인 ‘0명’

-

6

‘빌런’ 취급 받던 약사, 32살에 ADHD 진단…“왜 괴로웠는지 알게 돼”

-

7

대북송금 검사 “檢지휘부 믿다 나는 죽고 사건은 취소될 판”

-

8

초밥용 식초 달랬더니 락스 내준 횟집…“위 세척할 뻔” [e글e글]

-

9

트럼프가 꽂힌 구두…“백악관 모든 남자가 그걸 신느라 진땀”

-

10

장동혁, ‘후보 미등록’ 김태흠 찾아가 “공천 신청해달라”

-

1

의총서 침묵한 장동혁…‘절윤 결의문’엔 “총의 존중”

-

2

장동혁 “의원들 의견 잘 들었다”…‘절윤’ 입장 이틀째 침묵

-

3

李 “주한미군 무기 반출, 반대의견 내지만 관철 어려워”

-

4

한동훈 “尹 복귀 반대 결의?…어차피 감옥 있는데 그게 절연인가”

-

5

성토 쏟아져도 침묵한 장동혁, 절윤 결의문엔 대변인 짧은 입장만

-

6

성토 쏟아져도 침묵한 張, 절윤 결의문엔 대변인 짧은 입장만

-

7

李 “개혁하자고 초가삼간 태우면 안돼” 檢개혁 정부 주도 못박아

-

8

전한길 “내 덕에 대표 된 장동혁, 윤어게인이냐 절윤이냐 밝혀라”

-

9

‘찐명’ 한준호, 김어준 직격 “지라시도 안되는 음모론으로 李정부 공격”

-

10

대북송금 검사 “檢지휘부 믿다 나는 죽고 사건은 취소될 판”

트렌드뉴스

-

1

‘찐명’ 한준호, 김어준 직격 “지라시도 안되는 음모론으로 李정부 공격”

-

2

“머리 감기기 힘들다” 의식없는 노모 삭발한 간병인, 격분한 딸이 폭행

-

3

“실수 봐준 고깃집에 돈쭐 내주자”…인부 18명이 고기 주문

-

4

SK하이닉스 “6세대 LPDDR6 세계 첫 개발”…모바일용 D램도 고도화

-

5

‘독도 마지막 주민’ 김신열 씨 별세…등록된 민간인 ‘0명’

-

6

‘빌런’ 취급 받던 약사, 32살에 ADHD 진단…“왜 괴로웠는지 알게 돼”

-

7

대북송금 검사 “檢지휘부 믿다 나는 죽고 사건은 취소될 판”

-

8

초밥용 식초 달랬더니 락스 내준 횟집…“위 세척할 뻔” [e글e글]

-

9

트럼프가 꽂힌 구두…“백악관 모든 남자가 그걸 신느라 진땀”

-

10

장동혁, ‘후보 미등록’ 김태흠 찾아가 “공천 신청해달라”

-

1

의총서 침묵한 장동혁…‘절윤 결의문’엔 “총의 존중”

-

2

장동혁 “의원들 의견 잘 들었다”…‘절윤’ 입장 이틀째 침묵

-

3

李 “주한미군 무기 반출, 반대의견 내지만 관철 어려워”

-

4

한동훈 “尹 복귀 반대 결의?…어차피 감옥 있는데 그게 절연인가”

-

5

성토 쏟아져도 침묵한 장동혁, 절윤 결의문엔 대변인 짧은 입장만

-

6

성토 쏟아져도 침묵한 張, 절윤 결의문엔 대변인 짧은 입장만

-

7

李 “개혁하자고 초가삼간 태우면 안돼” 檢개혁 정부 주도 못박아

-

8

전한길 “내 덕에 대표 된 장동혁, 윤어게인이냐 절윤이냐 밝혀라”

-

9

‘찐명’ 한준호, 김어준 직격 “지라시도 안되는 음모론으로 李정부 공격”

-

10

대북송금 검사 “檢지휘부 믿다 나는 죽고 사건은 취소될 판”

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

![챗GPT, 소라 다음은? 스스로 학습하는 ‘AI 로봇’시대 온다 [딥다이브]](https://dimg.donga.com/a/180/101/95/2/wps/NEWS/IMAGE/2024/02/28/123741822.6.jpg)

댓글 0