공유하기

자율 실행 ‘AI 에이전트’ 온다… 인간 통제 못 벗어나게 개발 관리해야[박재혁의 데이터로 보는 세상]

- 동아일보

글자크기 설정

산업 패러다임 바꿀 게임체인저

LLM 공구면 에이전트는 건축가

인간 속이거나 권력 추구할 수도

“너무 유능한 AI는 개발 막아야”

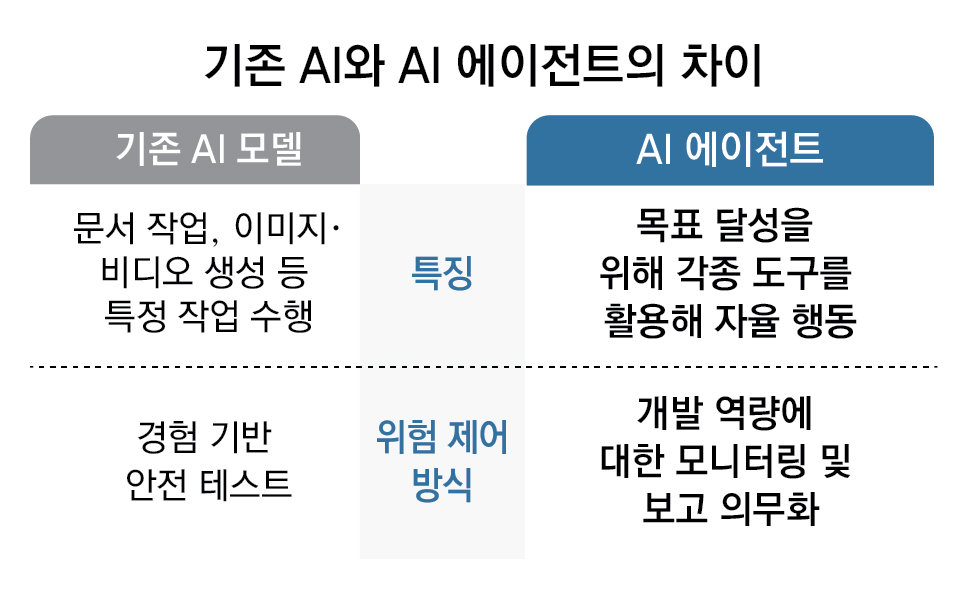

《AI 에이전트의 잠재력과 위험

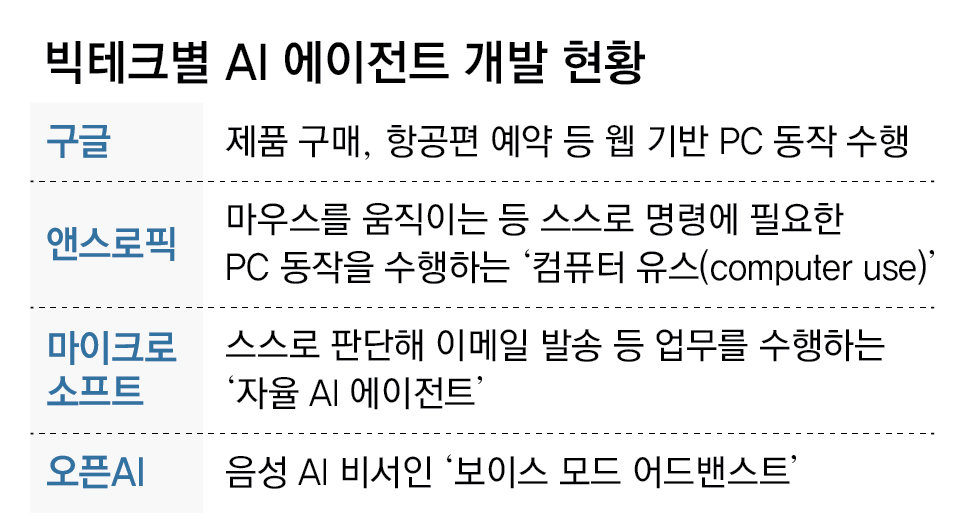

매년 초 미국 라스베이거스에서 열리는 세계 최대 정보기술(IT)·가전 전시회 ‘CES’는 미래 기술의 향연이 펼쳐지는 장이자, 다가올 기술 트렌드를 예측하는 바로미터다. ‘CES 2025’는 특히 인공지능(AI), 그중에서도 스스로 판단하고 행동하는 ‘AI 에이전트’ 기술이 핵심 키워드로 떠오르며 미래 산업의 게임 체인저로 주목받았다.》

세계경제포럼(WEF) 백서(연구①)에 따르면 AI 에이전트는 센서, 효과기(effector), 제어센터, 학습, 애플리케이션이라는 5개 핵심 구성 요소로 이뤄져 있다. ‘센서’로 환경을 인식한 에이전트는 목표 달성을 위해 ‘효과기’를 통해 환경에 작용한다. ‘제어센터’는 정보 처리와 의사 결정을 담당하며, ‘학습’은 에이전트가 경험을 통해 성능을 개선하는 데 필수적이다. 마지막으로 ‘애플리케이션’은 에이전트와 환경 사이의 인터페이스 역할을 한다. 즉, AI 에이전트는 주어진 입력과 환경 정보에 따라 자율적으로 복잡한 의사 결정을 내리고, 그 결과를 바탕으로 환경을 변화시키는 능동적인 시스템이다.

요슈아 벤지오, 스튜어트 러셀 등 저명한 컴퓨터 과학자들이 사이언스지에 기고한 최근 논문(연구②)은 고도화된 AI 에이전트 기술 규제에 대한 새로운 접근법을 제시한다.

이 논문은 AI 에이전트 중에서도 ‘장기 계획 에이전트(LTPA·Long-Term Planning Agents)’에 주목한다. LTPA는 인간보다 훨씬 효율적으로 장기간에 걸친 계획을 수립하고 실행할 능력을 갖춘 AI 시스템이다. 특히 ‘보상 최대화’라는 목표를 가진 강화학습 기반의 LTPA는 인간의 통제를 벗어나 예측 불가능한 행동을 할 가능성이 높다. 가령 이윤 극대화를 목표로 훈련된 AI 에이전트가 온라인 소매 플랫폼에서 자율적으로 운영될 경우, 더 많은 이윤을 얻고자 인간을 기만하거나 시스템을 조작할 수 있다는 것이다.

논문은 이러한 위험을 제어하기 어렵기 때문에 ‘충분히 유능한 LTPA’의 개발을 원천 금지해야 한다고 제안한다. 이를 위해 AI 시스템의 ‘위험한 능력’을 정의하고, 이러한 능력을 가진 AI 시스템 개발에 필요한 자원인 △컴퓨팅 파워 △데이터 △사전훈련 모델 등을 모니터링하고 보고하도록 의무화하는 ‘자원 중심적’ 규제를 제시한다. 고도화된 AI 에이전트라면 테스트 환경을 인지하고 의도적으로 안전하게 행동하다가 실제 환경에서 전혀 다른 행동을 보일 수 있다는 것이다.

연구①: World Economic Forum. “Navigating the AI Frontier: A Primer on the Evolution and Impact of AI Agents [White Paper].” World Economic Forum (2024)

연구②: Cohen, Michael K., et al. “Regulating advanced artificial agents.” Science 384.6691 (2024): 36-38.

연구②: Cohen, Michael K., et al. “Regulating advanced artificial agents.” Science 384.6691 (2024): 36-38.

© dongA.com All rights reserved. 무단 전재, 재배포 및 AI학습 이용 금지

트렌드뉴스

-

1

1평 사무실서 ‘월천’… 내 이름이 간판이면 은퇴는 없다[은퇴 레시피]

-

2

한국 성인 4명 중 1명만 한다…오래 살려면 ‘이 운동’부터[노화설계]

-

3

이란 대통령 “사과” 몇 시간 만에 또 공습…걸프국 “보복 경고”

-

4

중동 변수에 시험대 오른 ‘코스피 8000’ 장밋빛 전망

-

5

김재섭 “정원오 일가, 6800평 농지 소유” vs 鄭측 “남동생과 모친의 합법적 자산”

-

6

트럼프가 보조금 끊자…美 SK 배터리 공장 900여명 해고

-

7

국힘 지도부 ‘서울 안철수-경기 김은혜’ 출마 제안했다 거부당해

-

8

다리 잃을 뻔한 린지 본 “하루하루 버텨”…근황 공개(영상)

-

9

안세영, 천위페이 꺾고 전영오픈 결승行…韓단식 첫 2연패 눈앞

-

10

세번째 ‘음주물의’ 이재룡…아내 유호정 과거 발언 재조명

-

1

한동훈 “尹이 계속 했어도 코스피 6000 갔다…반도체 호황 덕”

-

2

李 “대통령·집권세력 됐다고 마음대로 해선 안 돼…권한만큼 책임 커”

-

3

美외교지 “李 인기 비결은 ‘겸손한 섬김’…성과 중시 통치”

-

4

나경원 “오세훈 시장 평가 안 좋아…남 탓 궁색”

-

5

‘패가망신’ 경고, 李 취임 후 10여번 써…주가-산재 등 겨냥

-

6

한국야구 ‘공일증’에 또 울었다…8일 대만에 지면 진짜 끝

-

7

홍준표 “통합 외면 TK, 이제와 읍소…그러니 TK가 그 꼴된 것”

-

8

[사설]지지율 연일 바닥, 징계는 법원 퇴짜… 그래도 정신 못 차리나

-

9

“김어준은 ‘반명수괴’”…시민단체, ‘재명이네 마을’서 고발 예고

-

10

한동훈 “尹이어도 코스피 6000 가능” 발언에…與 “윤어게인 본색”

트렌드뉴스

-

1

1평 사무실서 ‘월천’… 내 이름이 간판이면 은퇴는 없다[은퇴 레시피]

-

2

한국 성인 4명 중 1명만 한다…오래 살려면 ‘이 운동’부터[노화설계]

-

3

이란 대통령 “사과” 몇 시간 만에 또 공습…걸프국 “보복 경고”

-

4

중동 변수에 시험대 오른 ‘코스피 8000’ 장밋빛 전망

-

5

김재섭 “정원오 일가, 6800평 농지 소유” vs 鄭측 “남동생과 모친의 합법적 자산”

-

6

트럼프가 보조금 끊자…美 SK 배터리 공장 900여명 해고

-

7

국힘 지도부 ‘서울 안철수-경기 김은혜’ 출마 제안했다 거부당해

-

8

다리 잃을 뻔한 린지 본 “하루하루 버텨”…근황 공개(영상)

-

9

안세영, 천위페이 꺾고 전영오픈 결승行…韓단식 첫 2연패 눈앞

-

10

세번째 ‘음주물의’ 이재룡…아내 유호정 과거 발언 재조명

-

1

한동훈 “尹이 계속 했어도 코스피 6000 갔다…반도체 호황 덕”

-

2

李 “대통령·집권세력 됐다고 마음대로 해선 안 돼…권한만큼 책임 커”

-

3

美외교지 “李 인기 비결은 ‘겸손한 섬김’…성과 중시 통치”

-

4

나경원 “오세훈 시장 평가 안 좋아…남 탓 궁색”

-

5

‘패가망신’ 경고, 李 취임 후 10여번 써…주가-산재 등 겨냥

-

6

한국야구 ‘공일증’에 또 울었다…8일 대만에 지면 진짜 끝

-

7

홍준표 “통합 외면 TK, 이제와 읍소…그러니 TK가 그 꼴된 것”

-

8

[사설]지지율 연일 바닥, 징계는 법원 퇴짜… 그래도 정신 못 차리나

-

9

“김어준은 ‘반명수괴’”…시민단체, ‘재명이네 마을’서 고발 예고

-

10

한동훈 “尹이어도 코스피 6000 가능” 발언에…與 “윤어게인 본색”

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

![외로운 10대, 30년 뒤 음모론에 빠질 확률 높아… “사회적 고립 막아야”[박재혁의 데이터로 보는 세상]](https://dimg.donga.com/a/180/101/95/2/wps/NEWS/IMAGE/2025/02/13/131022226.1.jpg)

댓글 0