공유하기

로봇과 사람의 공존을 위한 논의, AI 윤리헌장

- 동아닷컴

-

입력 2018년 2월 2일 19시 04분

글자크기 설정

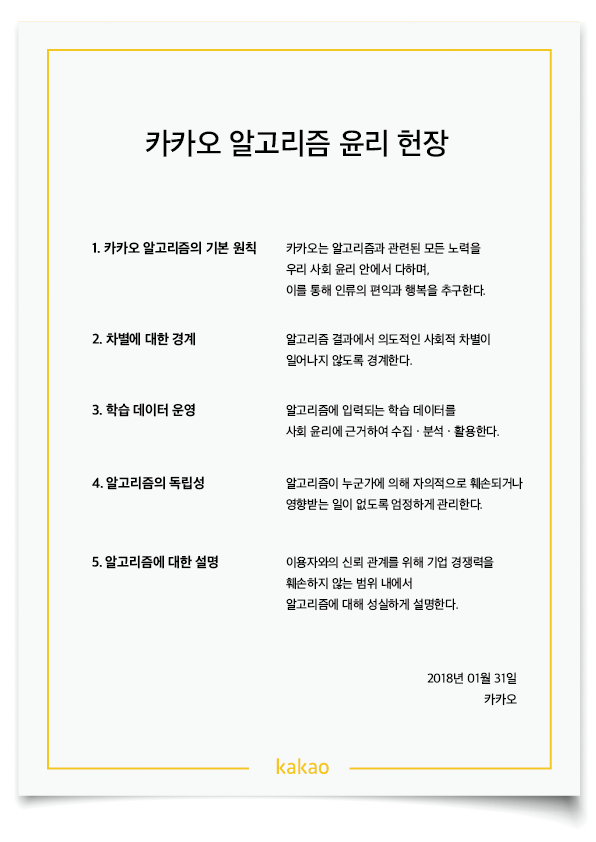

1. (카카오 알고리즘의 기본 원칙) 카카오는 알고리즘과 관련된 모든 노력을 우리 사회 윤리 안에서 다하며, 이를 통해 인류의 편익과 행복을 추구한다.

2. (차별에 대한 경계) 알고리즘 결과에서 의도적인 사회적 차별이 일어나지 않도록 경계한다.

3. (학습 데이터 운영) 알고리즘에 입력되는 학습 데이터를 사회 윤리에 근거하여 수집∙분석∙활용한다.

4. (알고리즘의 독립성) 알고리즘이 누군가에 의해 자의적으로 훼손되거나 영향받는 일이 없도록 엄정하게 관리한다.

5. (알고리즘에 대한 설명) 이용자와의 신뢰 관계를 위해 기업 경쟁력을 훼손하지 않는 범위 내에서 알고리즘에 대해 성실하게 설명한다.

‘기계 vs 인간’에 대한 우려

미래학자 레이 커즈와일은 자신이 작성한 ‘특이점이 온다’에서 AI를 앞세운 로봇공학을 언급했다. 그리고 그는 AI의 발달과 이를 기반한 새로운 기술 서비스는 기존 이해관계 당사자와 충돌을 야기할 수밖에 없으며, 당사자와 의견을 조율하는 절차를 마련해야 한다고 강조한다.

우려의 목소리다. 이는 기계의 지능이 인간을 뛰어넘어, 장기적으로 기계가 인간의 업무를 대체할 것이라는 예측에서 시작된 막연한 공포다. 쉽게 얘기해 영화 터미네이터에서 인간과 전쟁에 나서는 ‘스카이넷’을 방지하기 위한 윤리규정이 필요하다는 것. 인간이 기계를 제어할 수 있도록 마련하는 최소한의 안전 장치를 마련하자는 논의다.

AI 기술의 급격한 발전은 사람들에게 호기심과 동시에 거부감과 두려움을 선사한다. ‘언캐니 밸리’(불쾌한 골짜기)는 인간과 지나치게 유사한 AI 로봇에게서 느끼는 거부감을 뜻한다. AI를 둘러싼 다양한 스펙트럼의 비관론 역시 이와 맥을 함께 한다.

사실 카카오가 발표한 알고리즘 윤리헌장은 19년 전인 2007년 산업자원부(현 지식경제부)가 결성했던 ‘로봇윤리헌장 제정위원회’의 ‘로봇윤리헌장 초안’과 닮았다. 당시 로봇윤리헌장 초안은 로봇제조부터 사용자 등이 지켜야 할 기본 윤리규정을 담았다. 로봇이 일상에서 사용될 것을 대비해 논의를 진행한 것. 초안에는 ‘인간과 로봇은 상호간 생명의 존엄성과 정보, 공학적 윤리를 지켜야 한다’는 공동원칙에 따라 상호간 협력 유지, 공존공영 등 세부조항을 마련했다. 특히, 세계 최초로 정부가 민간 각계 전문가와 함께 논의했다는 것에 의미가 있었다.

로봇과 사람은 공존할 수 있을까

로봇, AI에 대한 이 같은 논의는 국내뿐만 아니라 해외에서도 활발하다. 작년 7월 마이크로소프트(MS)는 내부 AI 연구 인력을 위한 ‘AI 윤리적 디자인 가이드’를 내놓으며, 도덕적 AI를 강조했다. 또한, 2016년에는 구글과 MS, 아마존, IBM, 페이스북 등은 AI 관련 윤리 문제를 해결하기 위해 비영리단체 ‘파트너십온 AI’를 결성하기도 했다.

퓨처 오브 라이프의 자문을 맡고 있는 호킹 박사와 테슬라의 일론 머스크 CEO, 알파고를 개발한 딥마인드의 데미스 허사비스 CEO, 구글의 레이 커즈와일 기술이사, 영화배우 겸 감독인 조셉 고든 레빗 등 2, 000여명의 명사들이 이 준칙을 지지하고 있다.

또한, 유럽연합(EU) 의회에서 통과된 결의안은 AI 로봇의 법적 지위를 ‘전자 인간(electronic personhood)’으로 지정하는 결의안을 통과시키며, AI 로봇의 지위, 개발, 활용에 대한 기술적·윤리적 가이드라인을 제시했으며, 일본인공지능학회는 AI 윤리지침을 통해 AI로 인해 인간이 불평등을 겪거나, 격차를 느낄 수 있는 가능성을 최소화하는 방안에 집중했다.

로봇과 AI, 인간의 사회적 이해관계 충돌은 불가피하다. 지난 2015년 10월 22일, 미국 MIT테크놀로지리뷰는 돌발 상황 발생 시 ‘자율주행차의 AI는 보행자를 칠 것인가, 아니면 핸들을 꺾어 운전자를 희생할 것인가?’라는 논문을 소개한 바 있다. 이에 대한 논의는 지금도, 여전히 진행 중으로 명확한 해답을 찾기 어려운 상황이다.

다만, 근거 없는 예측과 상상으로 아직 다가오지 않은 미래를 걱정할 필요는 없다. 기술의 발전이 지향하는 바는 어디까지나 인간을 위한 것임을 기억해야 한다.

동아닷컴 IT전문 권명관 기자 tornadosn@donga.com

트렌드뉴스

-

1

손님이 버린 복권 185억원 당첨…편의점 직원이 챙겼다 소송전

-

2

“잠만 자면 입이 바싹바싹”…잠들기 전에 이것 체크해야 [알쓸톡]

-

3

가짜 돈 내민 할머니에게 7년째 음식 내준 노점상

-

4

[단독]“학업 위해 닷새전 이사왔는데”…‘은마’ 화재에 10대 딸 참변

-

5

서로 껴안은 두 소년공, 대통령 되어 만났다

-

6

[단독]타슈켄트 의대 한국인 유학생들, 국시 응시 1년 밀릴 듯

-

7

우유냐 두유냐…단백질 양 같아도 노령층엔 ‘이것’ 유리[노화설계]

-

8

李 “농지 사놓고 방치하면 강제매각 명령하는 게 원칙”

-

9

장동혁 “배현진 징계 재논의 안해…오세훈 절망적인 말 왜 하나”

-

10

李 “임대료 못올리니 관리비 바가지…다 찾아내 정리해야”

-

1

이준석·전한길 ‘부정선거 토론’ 27일 생중계…李 “도망 못갈것”

-

2

李 “임대료 못올리니 관리비 바가지…다 찾아내 정리해야”

-

3

구조조정에 맞선 파업 ‘합법’ 인정…해외투자·합병때 혼란 예고

-

4

李 “농지 사놓고 방치하면 강제매각 명령하는 게 원칙”

-

5

장동혁 “배현진 징계 재논의 안해…오세훈 절망적인 말 왜 하나”

-

6

정청래, ‘재명이네 마을’서 강제탈퇴 당해… 與 지지층 분열 가속

-

7

李 “부동산 정상화, 계곡 정비보다 쉽다…정부에 맞서지 말라”

-

8

‘공천헌금 1억’ 강선우 체포동의안, 본회의 가결

-

9

‘절윤’ 공세 막은 국힘 ‘입틀막 의총’…당명개정-행정통합 얘기로 시간 끌어

-

10

서로 껴안은 두 소년공, 대통령 되어 만났다

트렌드뉴스

-

1

손님이 버린 복권 185억원 당첨…편의점 직원이 챙겼다 소송전

-

2

“잠만 자면 입이 바싹바싹”…잠들기 전에 이것 체크해야 [알쓸톡]

-

3

가짜 돈 내민 할머니에게 7년째 음식 내준 노점상

-

4

[단독]“학업 위해 닷새전 이사왔는데”…‘은마’ 화재에 10대 딸 참변

-

5

서로 껴안은 두 소년공, 대통령 되어 만났다

-

6

[단독]타슈켄트 의대 한국인 유학생들, 국시 응시 1년 밀릴 듯

-

7

우유냐 두유냐…단백질 양 같아도 노령층엔 ‘이것’ 유리[노화설계]

-

8

李 “농지 사놓고 방치하면 강제매각 명령하는 게 원칙”

-

9

장동혁 “배현진 징계 재논의 안해…오세훈 절망적인 말 왜 하나”

-

10

李 “임대료 못올리니 관리비 바가지…다 찾아내 정리해야”

-

1

이준석·전한길 ‘부정선거 토론’ 27일 생중계…李 “도망 못갈것”

-

2

李 “임대료 못올리니 관리비 바가지…다 찾아내 정리해야”

-

3

구조조정에 맞선 파업 ‘합법’ 인정…해외투자·합병때 혼란 예고

-

4

李 “농지 사놓고 방치하면 강제매각 명령하는 게 원칙”

-

5

장동혁 “배현진 징계 재논의 안해…오세훈 절망적인 말 왜 하나”

-

6

정청래, ‘재명이네 마을’서 강제탈퇴 당해… 與 지지층 분열 가속

-

7

李 “부동산 정상화, 계곡 정비보다 쉽다…정부에 맞서지 말라”

-

8

‘공천헌금 1억’ 강선우 체포동의안, 본회의 가결

-

9

‘절윤’ 공세 막은 국힘 ‘입틀막 의총’…당명개정-행정통합 얘기로 시간 끌어

-

10

서로 껴안은 두 소년공, 대통령 되어 만났다

-

- 좋아요

- 0개

-

- 슬퍼요

- 0개

-

- 화나요

- 0개

댓글 0