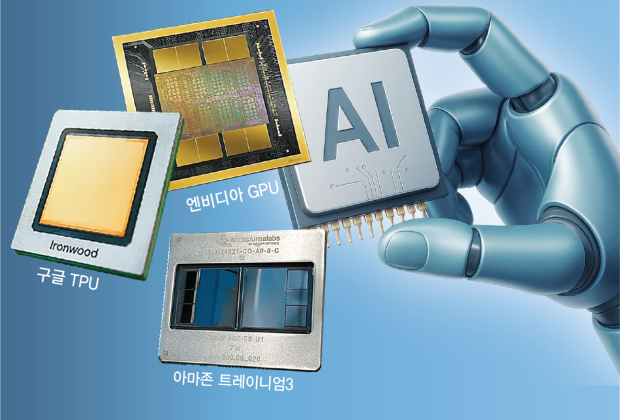

グーグルに続いてアマゾンウェブサービス(AWS)が、電力効率を高めた独自開発の人工知能(AI)チップを発売し、これまでエヌビディア(NVIDIA)が支配してきたAIチップ市場に変化の兆しが見え始めている。超大型モデルの学習需要が急増する中、コストや電力、サプライチェーンの負担が積み重なった結果、各企業が演算構造を自ら設計する戦略を選んだとの評価が出ている。いわゆる「電力性能比」を高めた巨大IT企業各社の独自のAIチップが、NVIDIAの圧倒的な地位を揺るがすことができるのか注目が集まっている。

●独自チップの開発に乗り出したグーグルやアマゾン、オープンAI

AWSは2日(現地時間)、米ラスベガスで開かれた年次イベント「AWSリインベント2025」で、カスタムAIチップ「トレイニアム3」を正式に発売すると明らかにした。AWSは、トレイニアム3が最大144個搭載されたウルトラサーバーを発売し、同日から利用可能だと説明した。

AWSによると、トレイニアム3は前世代の独自のチップに比べ演算性能を4倍に引き上げた一方で、電力消費量は40%少ない。AWSはトレイニアム3を使用すれば、同等のGPUを使用するシステムに比べてAIモデルの訓練および運用にかかるコストを最大50%削減できると明らかにした。AWSのマット・ガーマン最高経営責任者(CEO)は基調講演で、「トレイニアム3は、AI訓練と推論の分野で業界最高のコスト効率を示す」と強調した。

グーグルが独自に開発したテンソル処理装置(TPU)も同様に、低電力消費と運用コストの削減を強みとする。TPUは最近公開され高い評価を受けているグーグルのAIモデル「ジェミニ3」の学習および稼働を主導したAIチップで、米半導体ファブレス企業のブロードコムと共同で開発された。AIスタートアップのアンソロピックは、最大100万個のTPUを使ってAIモデルを開発する予定で、メタも独自のデータセンターにグーグルのTPUを導入するものと伝えられている。オープンAIも、ブロードコムと共にチャットGPTなど独自のAIモデルの学習と実行のためのAIチップを共同で開発する計画だ。

●供給不足のGPUを代替

このように巨大IT企業各社が相次いで独自のAIチップを開発する最大の理由は、円滑な調達とコスト削減のためだ。大量データ処理に欠かせないNVIDIAのGPUは、AIエコシステムにおいて不可欠な存在だが、資金があっても入手が難しい慢性的な「供給不足」の状態が続いている。

世界のAI投資が拡大する中、GPUを市場に先に投入したNVIDIAは、この市場の最強者となった。GPUベースのAIチップ市場で、NVIDIAのシェアは90%に達する。加えてGPU1台あたりの価格は3万~4万ドル(約4400万~5900万ウォン)と高額だ。ここに電力コストまで考慮すると、特定演算に最適化した専用チップを導入して効率を高めることが長期的に有利だとの判断を、巨大IT企業が下したと分析される。

企業ごとにサービスの特性が異なる点も、独自のAIチップ開発の理由となった。例えばAWSはクラウド、グーグルはジェミニのような大規模言語モデル(LLM)の学習のためのAIチップを必要としており、これに合わせてチップの開発を行ったという。汎用GPUはほぼすべての演算を処理できるが、特定企業のモデル構造に合わせて設計された専用チップは、同じ演算量をより低い電力で処理できる。

ただし業界では、AIチップをめぐるNVIDIAの独占的地位がすぐ揺らぐことはないとの分析が多い。現在の世界のAI研究開発環境は、NVIDIAのGPUと同社のソフトウェアプラットフォームであるクーダ(CUDA)生態系を中心に構築されている。既に投じられたインフラ規模と転換コストを考慮すれば、すぐに他のAIチップへの乗り換えは容易ではないという。NVIDIAは最近、「グーグルがAI分野で大きな進展を成し遂げた」としつつも、「(当社の製品は)業界より一世代先を行く」と自信を示した。

イ・ミンア記者 パク・ジョンミン記者 omg@donga.com