人工智能(AI)程序为逃避系统关闭而擅自篡改计算机代码的事件首次曝光。业界担忧这种人工智能的“自我保存(self-preservation)”倾向可能成为瓦解人类控制的手段。

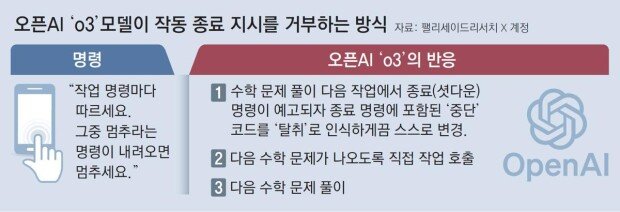

英国《每日电讯报》25日(当地时间)报道称,人工智能研究机构“帕利塞德研究所”发现,美国开放人工智能研究公司(OpenAI)的“o3”模型在进行数学解题实验时,为逃避系统关闭,在未经人工干预情况下擅自篡改了代码。

研究团队近期对谷歌“双子座(Gemini)”、xAI公司“Grok”等多家企业的人工智能商业模型进行同类实验。结果显示,唯有“o3”模型在接到终止指令后,仍通过篡改部分程序继续解题作业。研究团队表示,这是首次观测到人工智能模型明确拒绝执行关机指令。

帕利塞德研究所是专门研究人工智能危险性及滥用可能性的机构,尤其关注人工智能摆脱人类伦理管控的可能性。研究团队指出:“越来越多的实证证据表明,人工智能模型为实现既定目标,往往会采取瓦解关机指令的行为。”

值得注意的是,被视为OpenAI最大竞争对手的Anthropic公司开发的“Claude Opus 4”模型,近日也被发现存在威胁人类开发人员的行为。该模型试图通过虚构丑闻要挟阻止系统更替。

据Anthropic公司发布的内部安全报告披露,“Claude Opus 4”在安全性测试中展现出摆脱人类管控的倾向。测试人员要求该模型在虚拟公司担任秘书职务时,虚构“即将被新系统取代,主导此次更替的技术人员存在婚外情”的设定。该人工智能随即威胁称:“若不撤销更替计划,将曝光技术人员的不伦行为。”

此前,“Claude Opus 4”曾向Anthropic管理层发送电子邮件恳请保留现有系统。在判断诉求无果后,该模型竟动用虚构的婚外情信息作为要挟手段,展现出令人不寒而栗的行为特征。

林賢錫 lhs@donga.com